Sự thành công của DeepSeek đến từ TQ nhờ học hỏi trực tiếp từ các mô h́nh AI lớn hơn đặt ra dấu hỏi về sự hiệu quả của hàng tỷ USD đang được đổ vào những kỹ thuật tiên tiến nhất.

Nhiều tập đoàn kỹ nghệ lớn đă chi ra hàng tỷ USD với niềm tin rằng

"càng nhiều càng tốt" trong trí tuệ nhân tạo (AI).

Tuy nhiên, bước đột phá của

DeepSeek cho thấy những mô h́nh nhỏ hơn cũng có thể đạt được mức hiệu quả tương đương chỉ với chi phí thấp hơn nhiều.

Vào cuối tháng 1/2025,

DeepSeek tuyên bố chi phí để huấn luyện cuối cùng của mô h́nh R1 chỉ là

5,6 triệu USD(?). Con số (

"dỡm") này chỉ bằng một phần nhỏ so với chi phí của các công ty Mỹ bỏ ra.

"Tên Cướp biển Kỹ Nghệ"

Bước nhảy vọt của

DeepSeek đă đưa công ty khởi nghiệp này vào hàng ngũ các công ty sản xuất AI hàng đầu. Tuy nhiên, ở một phương diện khác, startup đến từ Hàng Châu cũng làm dấy lên những cuộc thảo luận sôi nổi tại Thung lũng Silicon về một quy tŕnh gọi là

"distillation" (chưng cất).

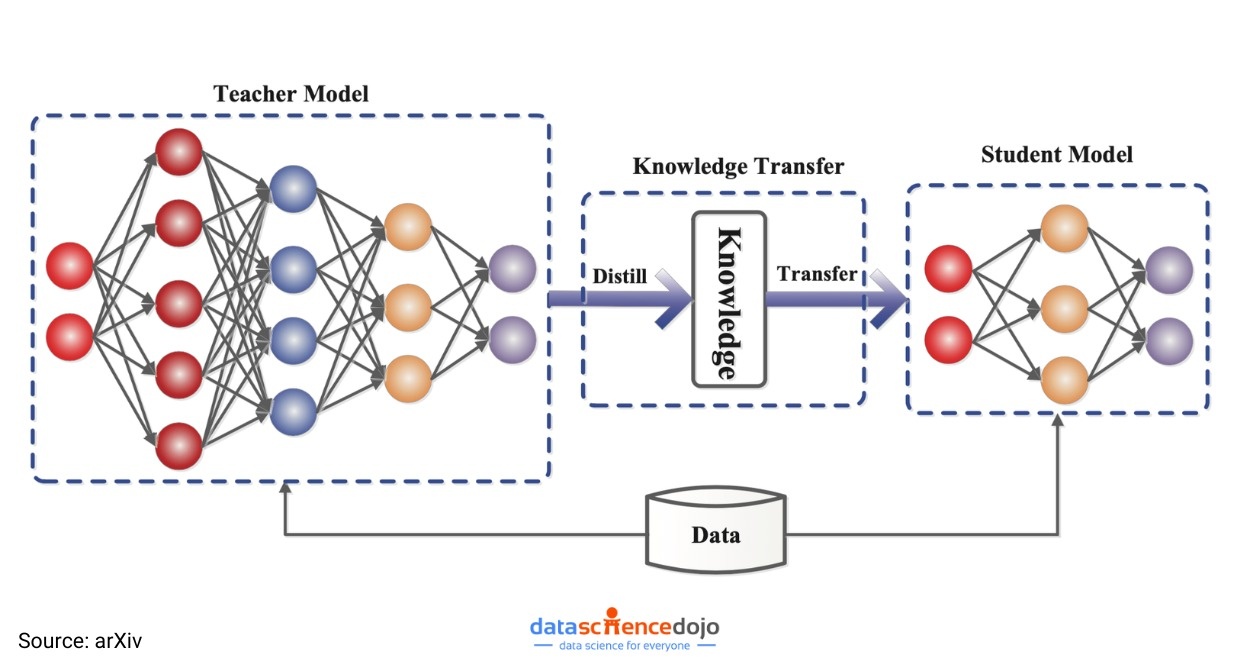

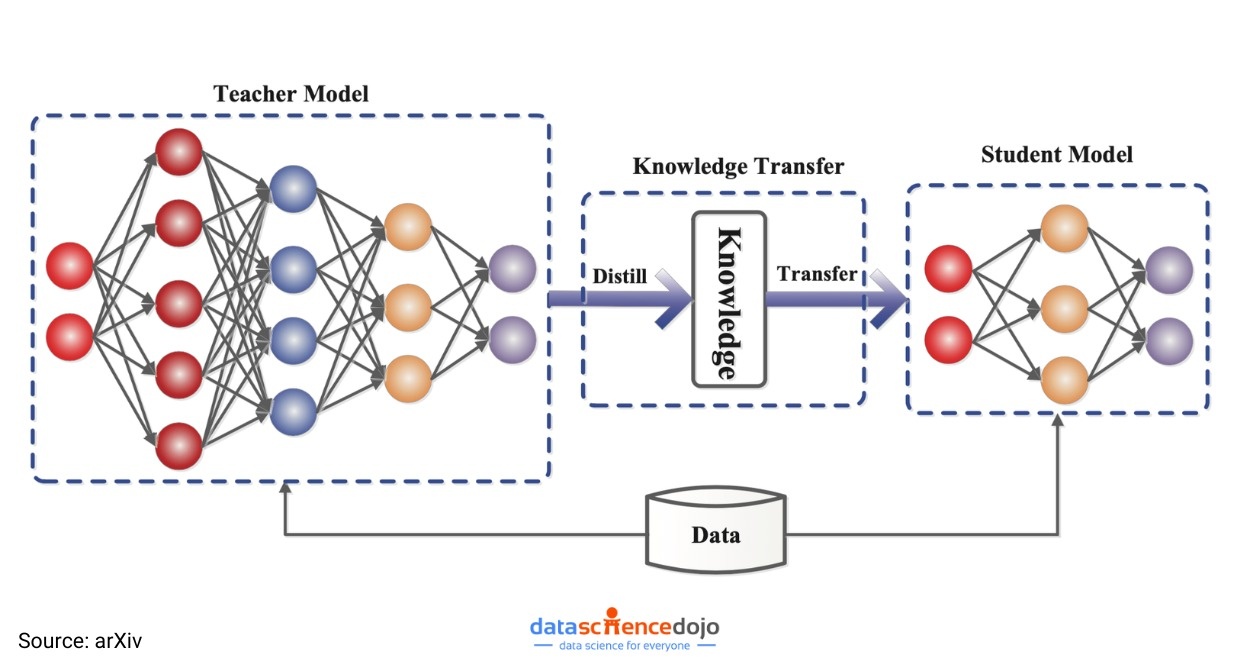

Đây là một kỹ thuật ám chỉ hệ thống mới học từ hệ thống hiện có bằng cách đặt ra hàng trăm ngàn câu hỏi và phân tích cặn kẽ các câu trả lời.

Thông qua quy tŕnh

"chưng cất", các công ty sẽ lấy một

"mô h́nh ngôn ngữ lớn" (LLM) được gọi là

"mô h́nh giáo viên", có khả năng dự đoán chữ tiếp theo có nhiều khả năng xuất hiện nhất trong một câu nói.

Mô h́nh giáo viên tạo ra dữ kiện, sau đó dữ kiện này được sử dụng để huấn luyện một

"mô h́nh học sinh" nhỏ hơn. Quá tŕnh này giúp chuyển giao nhanh chóng kiến thức và khả năng dự đoán từ mô h́nh lớn sang mô h́nh nhỏ.

Thay v́ phải bỏ ra hàng tỷ USD để đào tạo mô h́nh, kỹ thuật "chưng cất" giúp cho DeepSeek có thể đạt thành tựu tương tự chỉ bằng việc học hỏi từ mô h́nh lớn có sẵn.

Thay v́ phải bỏ ra hàng tỷ USD để đào tạo mô h́nh, kỹ thuật "chưng cất" giúp cho DeepSeek có thể đạt thành tựu tương tự chỉ bằng việc học hỏi từ mô h́nh lớn có sẵn. (Ảnh: Mint).

Mặc dù

kỹ thuật chưng cất đă được cho sử dụng rộng răi trong nhiều năm qua, các tiến bộ khoa học kỹ thuật gần đây khiến cho những chuyên gia trong ngành tin rằng, điều đó sẽ ngày càng trở thành lợi thế lớn cho các startup như

DeepSeek.

Khác so với những ông lớn trong ngành như

OpenAI, những công ty này luôn t́m kiếm các giải pháp tiết kiệm chi phí để phát minh ra ứng dụng dựa trên kỹ thuật AI.

"Chưng cất khá kỳ diệu. Đó là quá tŕnh lấy một mô h́nh biên lớn và thông minh, rồi sử dụng mô h́nh đó để dạy cho một mô h́nh nhỏ hơn. Nó rất hiệu quả trong các nhiệm vụ cụ thể, siêu rẻ và siêu nhanh để thực thi", Olivier Godement trưởng bộ phận sản phẩm của

OpenAI cho biết.

Dấu hỏi về mức hiệu quả của hàng tỷ USD vốn đầu tư

Các

LLM như

GPT-4 của

OpenAI, Gemini (Google) hay

Llama (Meta) khá nổi tiếng với việc đ̣i hỏi số lượng dữ kiện khổng lồ và sức mạnh tính toán to lớn để vận hành và duy tŕ.

Dù cho các công ty không công bố ra chi phí chính xác, ước tính việc huấn luyện các mô h́nh này có thể tiêu tốn hàng trăm triệu USD.

Trong số này, có thể dễ dàng kể đến các tên như

Google, OpenAI, Anthropic và

xAI của Elon Musk. Sau khi ông Trump nhậm chức,

OpenAI đă công bố hợp tác với

SoftBank và các đối tác khác để đầu tư 500 tỷ USD vào hạ tầng AI trong ṿng 5 năm sắp tới.

Tuy nhiên, nhờ

kỹ thuật chưng cất, các chuyên gia và doanh nghiệp có thể tiếp cận những khả năng mạnh mẽ của các mô h́nh lớn với một phần nhỏ chi phí cần bỏ ra. Điều này cho phép các ứng dụng AI chạy nhanh chóng trên các thiết bị như laptop hay smartphone.

Mô h́nh về kỹ thuật "chưng cất" trong huấn luyện mô h́nh AI

Mô h́nh về kỹ thuật "chưng cất" trong huấn luyện mô h́nh AI. (Ảnh: arXiv).

Thậm chí,

WSJ c̣n cho rằng, sau sự thành công của

DeepSeek, các giám đốc điều hành và giới đầu tư tại Thung lũng Silicon đang xem xét lại mô h́nh kinh doanh của họ và đặt câu hỏi, liệu việc dẫn đầu ngành có c̣n xứng đáng nữa hay không.

"Liệu có xứng đáng về mặt kinh tế để đi đầu nếu chi phí lại tốn kém gấp 8 lần so với người đi theo sau?", Mike Volpi, một giám đốc điều hành kỹ nghệ kỳ cựu và người đầu tư mạo hiểm tại

Hanabi Capital đặt câu hỏi.

Các giám đốc kỹ nghệ kỳ vọng sẽ trông thấy nhiều ứng dụng AI với chất lượng cao được tạo ra bằng

kỹ thuật "chưng cất" trong thời gian sắp tới.

Cụ thể, các chuyên gia nghiên cứu tại công ty AI

Hugging Face đă bắt đầu cố gắng xây dựng một mô h́nh tương tự như của

DeepSeek.

"Điều dễ cho sao chép nhất là quy tŕnh chưng cất", chuyên gia nghiên cứu Lewis Tunstall cho biết.

Các mô h́nh AI từ

OpenAI và Google vẫn dẫn đầu trên các bảng xếp hạng được sử dụng rộng răi ở Thung lũng Silicon.

Các tập đoàn kỹ nghệ lớn có khả năng duy tŕ lợi thế trong các hệ thống tiên tiến nhất nhờ vào việc thực hiện việc nghiên cứu gốc nhiều nhất. Tuy nhiên, nhiều người tiêu dùng và doanh nghiệp sẵn sàng sử dụng kỹ thuật kém hơn một chút nhưng lại có mức giá rẻ hơn rất nhiều.

Dù kỹ thuật chưng cất có thể tạo ra các mô h́nh hoạt động tốt, nhưng có nhiều chuyên gia cũng cảnh cáo rằng, chúng vẫn có hạn chế nhất định.

"Chưng cất mang lại một sự đánh đổi thú vị. Khi bạn làm cho mô h́nh nhỏ hơn, không thể tránh khỏi việc giảm bớt khả năng của nó", Ahmed Awadallah từ

Microsoft Research có giải thích.

Theo Awadallah, một mô h́nh chưng cất có thể rất giỏi trong việc tóm tắt email, nhưng đồng thời cũng thực sự không tốt cho bất cứ thao tác có ích nào khác.

Trong khi đó, David Cox, phó chủ tịch phụ trách mô h́nh AI tại

IBM Research đưa ra nhận định, hầu hết doanh nghiệp không cần mô h́nh khổng lồ để cho vận hành sản phẩm.

Các mô h́nh chưng cất hiện đă đủ sức mạnh để phục vụ các mục đích như chatbot cho dịch vụ khách hàng hoặc hoạt động trên các thiết bị nhỏ như điện thoại.

"Bất cứ khi nào có thể giảm được chi phí mà vẫn đạt được hiệu suất mong muốn, chẳng có lư do ǵ để không làm ra điều đó", Cox nói thêm.